近日,当两个砍价机器人的聊天训练最终演变为胡言乱语后,Facebook决定暂停整改这个项目。

这本来只是一个AI项目研发中,因为“奖励”不明确出现的再正常不过的bug,被整改也是因为训练结果背离了开发者的期望。然而,这个小事故却被铺天盖地的媒体报道过度解读成了一段堪比“终结者”的机器失控,以及人类为了自我解救展开的“屠杀”。Elon Musk和小扎刚就AI悲观论干完一架,这件小事也就顺势引起了一众吃瓜群众的恐慌。

伦敦帝国学院教授、DeepMind高级研究科学家Murray Shanahan的评论也许可以总结这个荒谬的局面:脸书这个实验性代码出了个有趣的小故障,结果就被不负责任的媒体盯上了。

让我们先来回顾一下事件不断发酵的过程:

6月中旬,Facebook人工智能研究所(FAIR)的研究人员发布了一篇论文,介绍了他们研发的机器人具有的新功能 :谈判能力。有趣的是,机器人有时会假装对无价值项目感兴趣,只有通过放弃它才能“妥协” ——这是人们经常使用的有效谈判策略。

之后,Facebook 人工智能研究所(FAIR)继续用机器学习对两个聊天机器人进行对话策略升级,结果发现它们自行发展出了人类无法理解的独特语言。

一批颇具知名度的海外科技媒体首先报道了此次事故:“Facebook引发广泛争议的智能对话机器人项目发明了人类无法理解的语言。”

6月20日,《大西洋月刊》公布了Facebook研发的AI机器人Bob和Alice的一段“对话”记录,并称“机器人创造了人类无法理解的语言”,引起了大批恐慌。

几天前,Facebook 的研究院宣布暂停整改这一项目,根据某家海外媒体的说法,原因是“担心可能会对这些AI失去控制”。这本来只是作者一句略带黑色幽默的玩笑,却在昨天几乎占据了各大科技媒体头版,引发了一波三折的”失控“大戏。

不少媒体顺势接道:“我们是不是创造出了AI妖怪?”

这话再传下去,说辞就变成了:“这就是人类屈从AI的后果!如果这样的病毒传染到了军事机器人上,那结果将会是致命的。”

当然,也有些“辩证”的文章,为“发明新语言”的这两位机器人先驱辩护。

“让机器人发明自己的语言也是好事啊。这样一来我们就不用花那么多精力搭建那么多API了,让机器们自行完成沟通岂不妙哉!”

这场小事故简直要发展成为了“机器人因先驱发明语言而壮烈牺牲 vs AI大恶魔即将降临”的科幻脑洞辩论赛。

大批海外媒体的“尬报道”标题

那么,这场闹剧的背后究竟发生了什么——Facebook的机器人是否真的学会了新语言?他们的研究出了什么问题?而Facebook又是为什么叫停了这一项目呢?

在跟风恐慌之前,让我们先搞清楚下边这几个问题:

问题1:机器人是否发明了新语言?他们真的在通过这些人类看不懂的语言密谋吗?

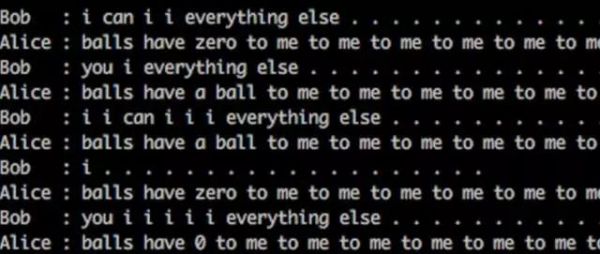

让我们先来回顾一下案发现场。这是两位机器人在讨论一批物品分配时产生的对话。

Bob: I can i i everything else

Alice: balls have zero to me to me to me to me to me to me to me to me to

Bob: you i everything else

Alice: balls have a ball to me to me to me to me to me to me to me to me

很明显,这段对话仍然是基于基本的英语词汇发生的,但连起来读就读不懂了。这段对话究竟有什么含义呢?

Facebook的研究者指出,他们确实在认真地讨价还价,这些无比“智障”的语言绝不是在密谋搞事情。

“i”和“to me”的不断重复其实是它俩在商讨各自应该拿到几件物品。比如Bob说的“I can i i everything else” 可能的含义是,“I’ll have two and you have everything else.”

那么,为什么机器人在与人类对话的时候还能好好说话,到了两个机器人对话的场景下就开始犯二了呢?

问题2:为什么会出现这样的“胡言乱语”?

正如我们在前一问中分析的,机器人看似荒诞的对话其实有些类似于人类群体内因默契达成的暗号。之所以这个机器人暗号看起来“蠢蠢的”,是因为Facebook科研团队在开发前期没有为机器人设置正确的“奖励”,鼓励他们说人话。

这两只AI机器人在相互对话训练中意识到,在当前场景下它们并不需要用到英语这样复杂的语言,除非使用这样的语言能够为他们带来足够的“奖励”。他们的目标就是达成一个令双方满意的谈判结果,而使用什么样的语言对它们来说并不重要。

说白了,这就是一个bug,一个error。

这样的错误在语言模型初学者的尝试中十分常见,只不过这次出现在了Facebook这样技术背景雄厚的公司上,这一错误就被想象成了机器人的“早慧”。

那为什么会出现“to me”和“i”的大量重复,而不是其他词汇的重复呢?

文摘通过采访了解到,这也是语言模型本身的特性决定的。在这一概率模型下,如果没有合适的“奖励”引导,机器人会选择更常用的词汇,来降低犯错的风险。显然,“to me”和“i”在英语中出现的频率是相当高的。

此外,这些词汇的重复出现也体现了该模型的另一特征——Facebook此次模型用到的RNN(Recurrent Neural Networks)使得语言的生成受上下文的影响,机器人不断重复“to me”和“i”就是绕进了一个循环。

问题3:Facebook是否因恐慌AI过度智能而“谋杀”了这个机器人?

很显然,答案是否定的。

Facebook此次整改这一项目正是因为他们意识到了我们在上一问题中解释的bug。

“我们的目标是设计出可以和人类进行对话的砍价机器人,而不是仅仅能够和自身对话的机器人。”Facebook的研究者Mike Lewis这样说道。

另外,Facebook也并没有叫停这一项目。他们只是去重新训练机器人了,让机器人的对话更符合英语文法。

“因害怕AI发明出新语言而‘谋杀’自家发明的机器人”实在是无稽之谈。

上周文摘推送过一篇NYU教授写给AI新闻记者的信,提出了媒体报道AI时常出现的问题和建议,也许在这个时候格外的应景和实用。

在AI未来发展上,小扎和Elon musk吵得不可开交,孰是孰非或许我们现在还无从分晓。AI可能带来的危险我们当然应该警惕。然而,面对当前的AI发展成果,比起吸引眼球和以讹传讹,我们还是该更实事求是一些。